알리바바 EMO AI 모델로 말하고 노래하는 인물 영상 만드는 법

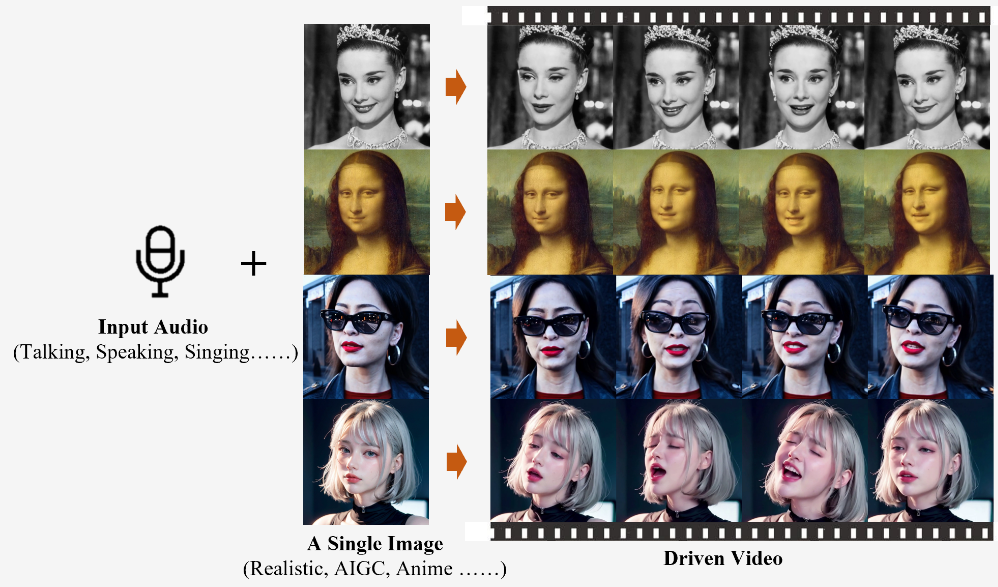

알리바바 그룹의 지능형 컴퓨팅 연구소(Institute for Intelligent Computing)는 최근 EMO라는 혁신적인 AI 영상 생성 모델을 선보였습니다. 이 기술은 단순히 이미지를 변환하는 것을 넘어서, 하나의 레퍼런스 이미지와 오디오 파일을 결합하여 말하고, 노래하는 인물의 영상을 창출할 수 있는 능력을 가지고 있습니다.

AI로 생성한 이미지와 오디오를 넣은 것만으로도 다음과 같이 영상이 만들어졌습니다.

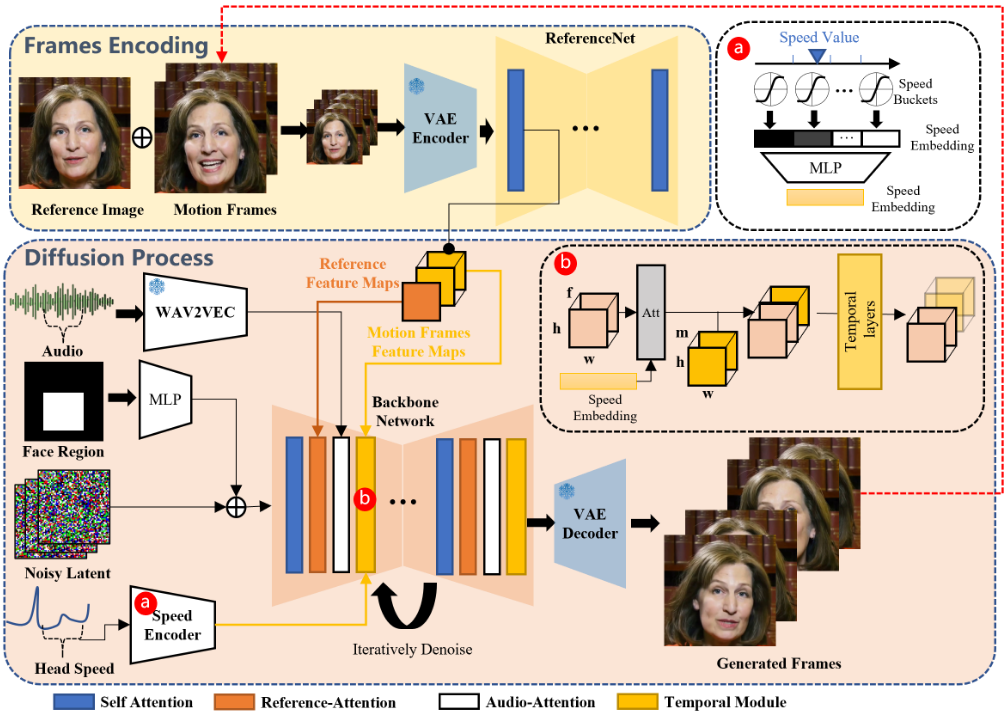

EMO의 작동 원리

EMO 모델은 사용자가 제공한 사진과 오디오 클립을 기반으로 인물이 말하거나 노래하는 영상을 생성합니다.

이 과정에서 가장 인상적인 것은 아래 사진과 같이 생성된 인물의 표정이 매우 풍부하며, 말하는 내용과 입 모양이 자연스러운 일치를 보인다는 점입니다.

EMO AI는 오디오 입력과 참조 이미지를 기반으로 한 인물의 얼굴 이미지를 생성하는 AI 기반 프레임워크입니다.

이 프레임워크는 프레임 인코딩과 확산 프로세스 단계로 구성되어 있습니다.

- 프레임 인코딩 단계:

- 이 단계에서는 ReferenceNet이라는 컴포넌트가 사용됩니다.

- ReferenceNet의 주요 역할은 참조 이미지(예: 인물의 얼굴 사진)와 모션 프레임(예: 움직임 정보를 담고 있는 데이터)에서 특징을 추출하는 것입니다.

- 이 과정을 통해 시스템은 참조 이미지와 모션 데이터의 중요한 정보를 인코딩하고 저장합니다.

- 확산 프로세스 단계:

- 이 단계에서는 오디오 데이터 처리를 위해 사전 훈련된 오디오 인코더가 도입됩니다.

- 오디오 임베딩은 음성이나 음악 등 오디오 데이터의 특징을 추출하여 저장하는 과정입니다.

- 얼굴 영역 마스크와 다중 프레임 노이즈가 통합되어, 생성될 얼굴 이미지의 형태와 특징을 제어합니다.

- 이 과정에서 백본 네트워크가 중요한 역할을 합니다. 백본 네트워크는 잡음을 제거하는 과정을 용이하게 하며, 이미지 생성의 기본 구조를 제공합니다.

- 프레임워크 내에는 두 가지 주요 Attention 메커니즘이 적용됩니다:

- Reference-Attention: 캐릭터의 정체성을 보존하는 데 중요합니다. 즉, 참조 이미지의 특징을 기반으로 생성된 이미지가 해당 인물과 일치하도록 합니다.

- Audio-Attention: 오디오 데이터와 이미지 사이의 동기화를 담당합니다. 이 메커니즘을 통해 캐릭터의 움직임과 오디오 입력이 자연스럽게 매칭되도록 조절합니다.

- 또한, 시간 모듈은 생성된 이미지의 동작 속도와 시간 차원을 조절하는 데 사용됩니다. 이를 통해 생성된 영상이 더 자연스러운 동작과 타이밍을 가지도록 합니다.

이 프레임워크는 참조 이미지와 오디오 데이터를 통합하여, 인물의 얼굴 이미지를 말하거나 노래하는 동작으로 생성하는 복잡한 과정을 구현합니다. 여기에는 이미지와 오디오 데이터 간의 정교한 동기화가 필요하며, 생성된 이미지가 실제 인물의 모습과 움직임을 자연스럽게 반영하도록 다양한 기술이 사용됩니다.

깃허브를 통한 공개

현재 EMO 모델은 깃허브를 통해 공개되었으나, 모델의 개선과 안정성 확보를 위한 추가적인 테스트가 필요하여 아직 일반 사용자에게는 배포되지 않았습니다.

관심 있는 이용자들은 깃허브의 공식 문서를 통해 모델에 대한 더 많은 정보를 얻을 수 있습니다.

EMO의 놀라운 영상 샘플들

EMO를 통해 생성된 영상 샘플들은 그 가능성과 창의성을 널리 보여주고 있습니다.

예를 들어, 오드리 햅번의 사진과 사만다 하비가 커버한 Ed Sheeran의 "Perfect"를 결합한 영상은 마치 고전적인 영화 스타가 현대 음악에 맞춰 노래하는 것처럼 보입니다.

또한, 모나리자의 이미지와 여자아이들의 우기가 커버한 Miley Cyrus의 "Flowers"를 합친 영상은, 고전 미술과 현대 음악의 흥미로운 결합을 보여줍니다.

빠른 리듬의 가사와 표현도 가능합니다.

단순히 노래에 포함된 오디오 입력 뿐만 아니라 다양한 언어로 된 음성 오디오 또한 효과적으로 처리할 수 있는 능력을 갖추고 있어, 전 세계 다양한 문화와 언어의 오디오 콘텐츠를 지원합니다.

더 나아가, 과거의 인물 사진, 예술 작품 그림, 3D 모델, 그리고 최신 AI 기술로 생성된 콘텐츠까지도 다룰 수 있는 광범위한 적용 범위를 자랑합니다.

이들 다양한 형태의 참조 자료를 사용하여, 실제와 같은 움직임과 사실감을 가진 애니메이션을 창조해냅니다.

즉, 과거의 유명 인사나 역사 속 인물, 심지어는 상상 속의 캐릭터까지도 생동감 넘치는 형태로 되살릴 수 있습니다.

다양한 AI 모델의 공개

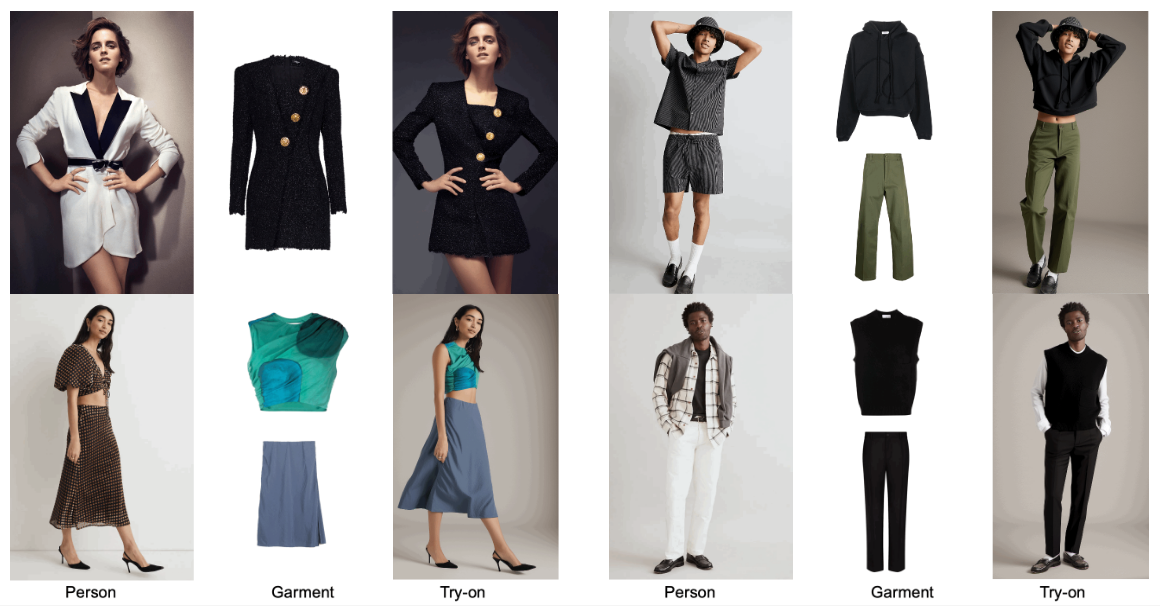

알리바바 그룹의 지능형 컴퓨팅 연구소는 EMO 외에도 다양한 AI 기술을 개발하고 있습니다.

Animate Anyone 모델과 같이 이미지 속 인물이나 캐릭터를 춤추게 하는 기술은 대중의 큰 관심을 받고 있습니다.

이러한 모델들은 엔터테인먼트, 교육, 마케팅 등 다양한 분야에서 활용될 잠재력을 가지고 있습니다.

EMO와의 첫 만남

개인적으로, 최근 OpenAI의 Sora 모델에 의해 제공된 강력한 인상 이후, EMO를 접하는 것은 신선한 충격이었습니다. EMO가 생성한 영상들은 AI 기술이 인간의 창의성을 어떻게 확장할 수 있는지를 보여주는 또 다른 예입니다.

더 많은 EMO 영상을 원하시나요?

EMO로 생성된 더 많은 영상을 보고 싶다면, 깃허브의 공식 문서를 방문하거나 알리바바 그룹의 지능형 컴퓨팅 연구소 웹사이트를 확인해보세요. 이들 페이지에서는 EMO 모델을 통해 만들어진 다양하고 매혹적인 영상 샘플들을 제공합니다.

'IT > AI' 카테고리의 다른 글

| 글쓰기를 위한 AI 서비스, 뤼튼 AI 소개 및 사용법과 요금제 안내(feat. GPT4 무료 사용하는 법) (0) | 2024.02.29 |

|---|---|

| AI 리모델링 서비스 Remodel AI 고급 인테리어 디자인하는 법 (0) | 2024.02.29 |

| [AI] OpenAI Sora Text to Video 생성 모델, 게임 랜더링 기능 포함 (feat. 마인크래프트) (0) | 2024.02.20 |

| [AI] OpenAI Sora 사용법과 출시일 및 가격 정보, 텍스트로 영상 만들기 (0) | 2024.02.16 |

| [AI] 스테이블 디퓨전 메모리 부족 문제 해결 방법 (0) | 2023.12.19 |

댓글